如何構建Ceph-創(chuàng)新互聯(lián)

小編給大家分享一下如何構建Ceph,希望大家閱讀完這篇文章之后都有所收獲,下面讓我們一起去探討吧!

成都創(chuàng)新互聯(lián)自2013年創(chuàng)立以來,先為磐石等服務建站,磐石等地企業(yè),進行企業(yè)商務咨詢服務。為磐石企業(yè)網站制作PC+手機+微官網三網同步一站式服務解決您的所有建站問題。

基本簡介

Ceph是一種為優(yōu)秀的性能、可靠性和可擴展性而設計的統(tǒng)一的、分布式文件系統(tǒng)。

由來

其命名和UCSC(Ceph 的誕生地)的吉祥物有關,這個吉祥物是 “Sammy”,一個香蕉色的蛞蝓,就是頭足類中無殼的軟體動物。這些有多觸角的頭足類動物,是對一個分布式文件系統(tǒng)高度并行的形象比喻。

Ceph 最初是一項關于存儲系統(tǒng)的 PhD 研究項目,由 Sage Weil 在 University of California, SantaCruz(UCSC)實施。

開發(fā)目標

簡單定義為以下3項:

可輕松擴展到數 PB 容量

支持多種工作負載的高性能(每秒輸入/輸出操作[IOPS]和帶寬)

高可靠性

但是,這些目標之間會互相競爭(例如,可擴展性會降低或者抑制性能或者影響可靠性)。Ceph 的設計還包括保護單一點故障的容錯功能,它假設大規(guī)模(PB 級存儲)存儲故障是常見現(xiàn)象而不是例外情況。

它的設計并沒有假設某種特殊工作負載,但包括了適應變化的工作負載,并提供最佳性能的能力。它利用 POSIX 的兼容性完成所有這些任務,允許它對當前依賴 POSIX 語義(通過以 Ceph 為目標的改進)的應用進行透明的部署。

系統(tǒng)架構

Ceph 生態(tài)系統(tǒng)架構可以劃分為四部分:Clients:客戶端(數據用戶)

cmds:Metadata server cluster,元數據服務器(緩存和同步分布式元數據)

cosd:Object storage cluster,對象存儲集群(將數據和元數據作為對象存儲,執(zhí)行其他關鍵職能)

cmon:Cluster monitors,集群監(jiān)視器(執(zhí)行監(jiān)視功能)

內容源自百科:https://baike.baidu.com/item/CEPH/1882855

操作過程

CEPH環(huán)境配置

192.168.27.210 master(ceph-deploy)

192.168.27.211 client1 osd0 mds1、mon1

192.168.27.212 client2 osd1 mds2、mon2

192.168.27.213 client3 osd2 mds3、mon3

主機名

hostnamectl set-hostname master

hostnamectl set-hostname client1

hostnamectl set-hostname client2

hostnamectl set-hostname client3

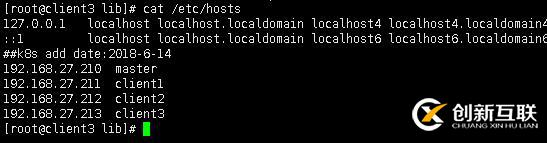

映射主機名:

192.168.27.210 master

192.168.27.211 client1

192.168.27.212 client2

192.168.27.213 client3

確認節(jié)點間映射關系的聯(lián)通性:

ping -c 3 master

ping -c 3 client1

ping -c 3 client2

ping -c 3 client3

提示:由于提前做了SSH免登陸,這里把步驟省了,新裝需要每臺都需要做一次。

每個節(jié)點關閉防火墻和selinux

#systemctl stop firewalld

#systemctl disable firewalld

#sed -i 's/SELINUX=enforcing/SELINUX=disabled/g' /etc/selinux/config

#setenforce 0每個節(jié)點安裝和配置NTP(官方推薦的是集群的所有節(jié)點全部安裝并配置 NTP,需要保證各節(jié)點的系統(tǒng)時間一致。沒有自己部署ntp服務器,就在線同步NTP)

#yum install ntp ntpdate ntp-doc -y

#systemctl restart ntpd

systemctl status ntpd

每個節(jié)點準備yum源

刪除默認的源,國外的比較慢

#yum clean all

#mkdir /mnt/bak

#mv /etc/yum.repos.d/* /mnt/bak/

下載阿里云的base源和epel源

#wget -O /etc/yum.repos.d/CentOS-Base.repo http://mirrors.aliyun.com/repo/Centos-7.repo

#wget -O /etc/yum.repos.d/epel.repo http://mirrors.aliyun.com/repo/epel-7.repo

添加ceph源

#vim /etc/yum.repos.d/ceph.repo

[ceph]

name=ceph

baseurl=http://mirrors.aliyun.com/ceph/rpm-jewel/el7/x86_64/

gpgcheck=0

priority =1

[ceph-noarch]

name=cephnoarch

baseurl=http://mirrors.aliyun.com/ceph/rpm-jewel/el7/noarch/

gpgcheck=0

priority =1

[ceph-source]

name=Ceph source packages

baseurl=http://mirrors.aliyun.com/ceph/rpm-jewel/el7/SRPMS

gpgcheck=0

priority=1

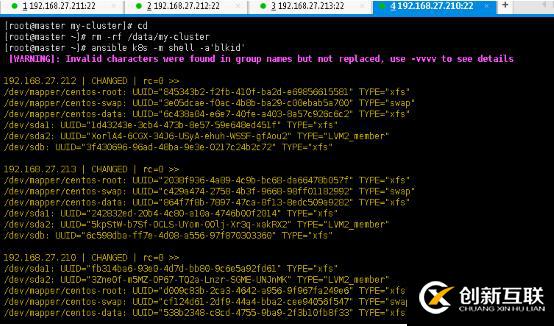

準備磁盤(實際操作也可以省,只要磁盤沒問題直接安裝都沒問題無需要此步驟)

fdisk /dev/sdb

parted -s /dev/sdb mklabel gpt mkpart primary xfs 0% 100%

mkfs.xfs /dev/sdb –f

blkid /dev/sdb #用ansible直觀的看下

部署階段(admin節(jié)點上使用ceph-deploy快速部署)

安裝ceph-deploy

sudo yum update -y && sudo yum install ceph-deploy -y

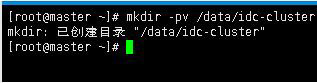

創(chuàng)建cluster目錄

[root@master ~]# mkdir -pv /data/idc-cluster

mkdir: 已創(chuàng)建目錄 "/data/idc-cluster"

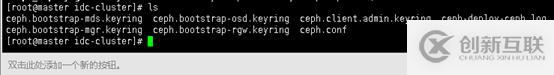

創(chuàng)建集群(后面跟集群成員節(jié)點名稱,這里master節(jié)點只做CEPH-DEPLOY使用)

[root@master idc-cluster]# ceph-deploy new client1 client2 client3

在ceph.conf文件中添加紅色項并保存

[root@client2 ceph]# cat ceph.conf

[global]

fsid = d5a5f367-97d2-45a5-8b6b-b462bd65fe3d

mon_initial_members = client1, client2, client3

mon_host = 192.168.27.211,192.168.27.212,192.168.27.213

auth_cluster_required = cephx

auth_service_required = cephx

auth_client_required = cephx

osd_pool_default_size= 3

public_network = 192.168.27.0/22

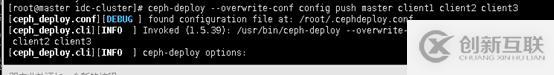

重新推送配置信息到各結點:

[root@master idc-cluster]# ceph-deploy --overwrite-conf config push master client1 client2 client3

初始化集群:

ceph-deploy mon create-initial

添加OSD到集群

準備OSD(使用prepare命令)

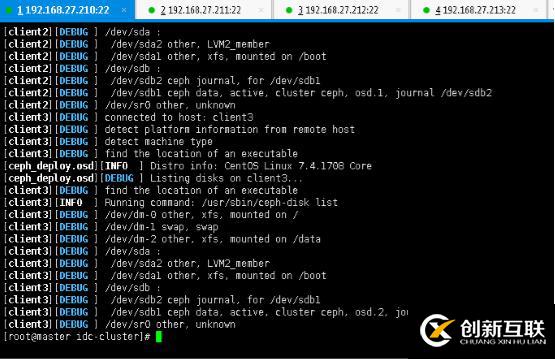

[root@master idc-cluster]# ceph-deploy osd prepare client1:/dev/sdb client2:/dev/sdb client3:/dev/sdb

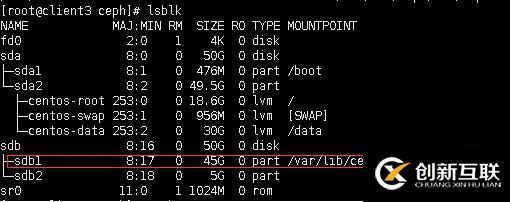

激活OSD(注意由于ceph對磁盤進行了分區(qū),/dev/sdb磁盤分區(qū)為/dev/sdb1)

[root@master idc-cluster]# ceph-deploy osd activate client1:/dev/sdb1 client2:/dev/sdb1 client3:/dev/sdb1

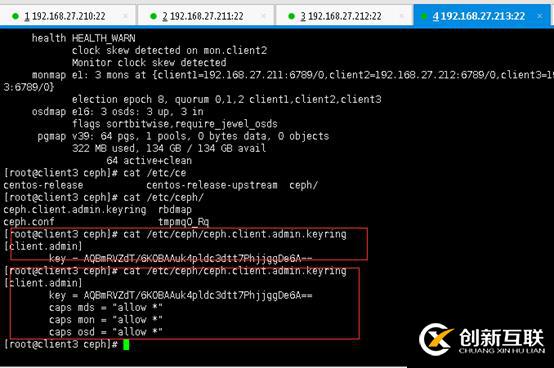

[root@master idc-cluster]# ceph-deploy admin master client1 client2 client3

創(chuàng)建文件系統(tǒng)

先查看管理節(jié)點狀態(tài),默認是沒有管理節(jié)點的。

[root@master idc-cluster]# ceph mds stat

e1:

[root@master idc-cluster]#

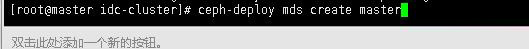

創(chuàng)建管理節(jié)點(master結點作為管理節(jié)點)

[root@master idc-cluster]# ceph-deploy mds create master

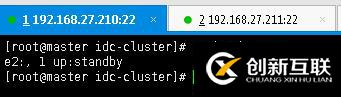

再次查看管理節(jié)點狀態(tài),發(fā)現(xiàn)已經在啟動中

[root@master idc-cluster]# ceph mds stat

e2:, 1 up:standby

創(chuàng)建pool,pool是ceph存儲數據時的邏輯分區(qū),它起到namespace的作用

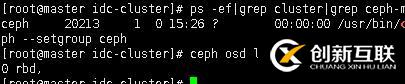

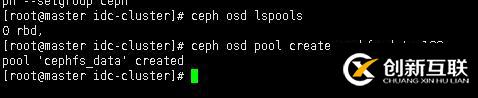

先查看下:

ceph osd lspools

新創(chuàng)建的ceph集群只有rdb一個pool。這時需要創(chuàng)建一個新的pool

[root@master idc-cluster]# ceph osd pool create cephfs_data 128 #后面的數字是PG的數量

pool 'cephfs_data' created

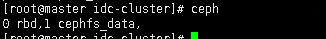

再查看下有了:

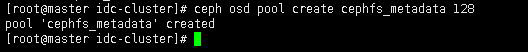

[root@master idc-cluster]# ceph osd pool create cephfs_metadata 128 #創(chuàng)建pool的元數據

pool 'cephfs_metadata' created

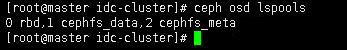

再次查看pool狀態(tài):

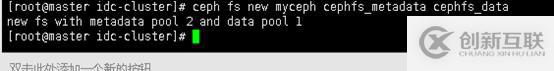

ceph fs new myceph cephfs_metadata cephfs_data

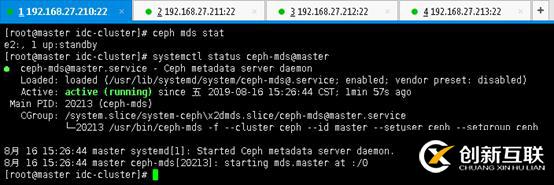

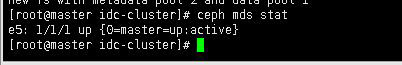

檢查mds管理節(jié)點狀態(tài)

[root@master idc-cluster]# ceph mds stat

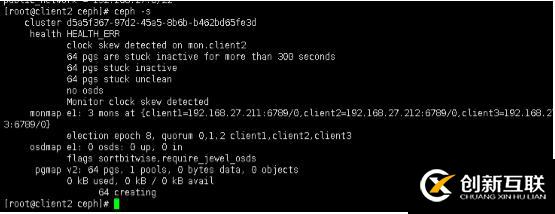

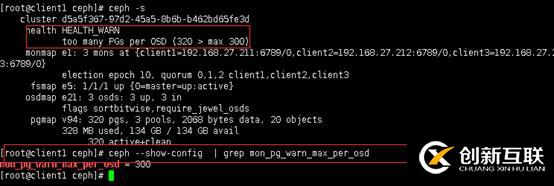

查看集群狀態(tài)有警報:

解決方案

在配置文件中,調大集群的此選項的告警閥值;方法如下,在mon節(jié)點的ceph.conf(/etc/ceph/ceph.conf)配置文件中添加:

vi /etc/ceph/ceph.conf

[global]

.......

mon_pg_warn_max_per_osd = 666

推送配置

重啟monitor服務:

systemctl restart ceph-mon.target

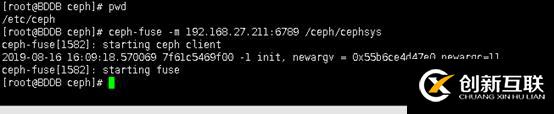

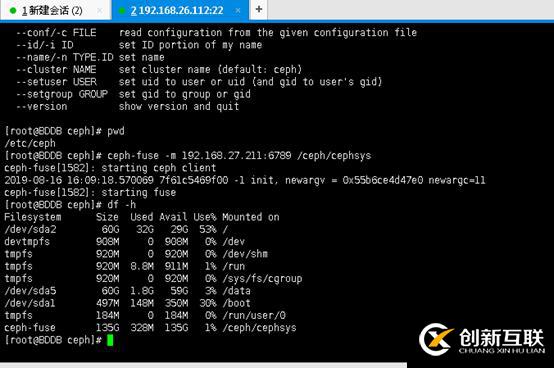

1、客戶端掛載使用cephfs:

[root@BDDB ceph]# ceph-fuse -m 192.168.27.211:6789 /ceph/cephsys

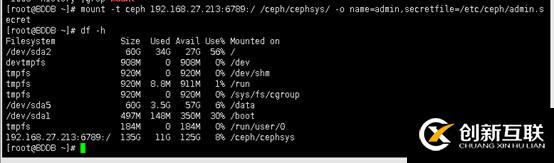

2、使用內核驅動程序掛載CephFs

[root@BDDB ~]# mount -t ceph 192.168.27.213:6789:/ /ceph/cephsys/ -o name=admin,secretfile=/etc/ceph/admin.secret

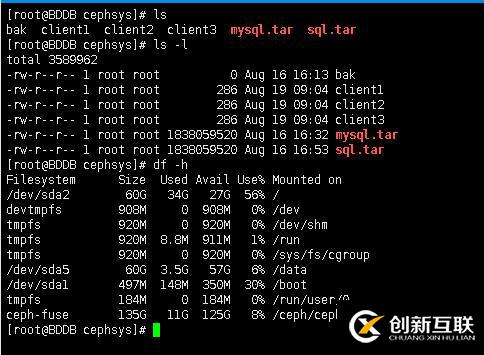

存放文件效果:

看完了這篇文章,相信你對“如何構建Ceph”有了一定的了解,如果想了解更多相關知識,歡迎關注創(chuàng)新互聯(lián)行業(yè)資訊頻道,感謝各位的閱讀!

另外有需要云服務器可以了解下創(chuàng)新互聯(lián)cdcxhl.cn,海內外云服務器15元起步,三天無理由+7*72小時售后在線,公司持有idc許可證,提供“云服務器、裸金屬服務器、高防服務器、香港服務器、美國服務器、虛擬主機、免備案服務器”等云主機租用服務以及企業(yè)上云的綜合解決方案,具有“安全穩(wěn)定、簡單易用、服務可用性高、性價比高”等特點與優(yōu)勢,專為企業(yè)上云打造定制,能夠滿足用戶豐富、多元化的應用場景需求。

名稱欄目:如何構建Ceph-創(chuàng)新互聯(lián)

當前網址:http://vcdvsql.cn/article26/cdghjg.html

成都網站建設公司_創(chuàng)新互聯(lián),為您提供定制網站、網頁設計公司、網站維護、Google、關鍵詞優(yōu)化、移動網站建設

聲明:本網站發(fā)布的內容(圖片、視頻和文字)以用戶投稿、用戶轉載內容為主,如果涉及侵權請盡快告知,我們將會在第一時間刪除。文章觀點不代表本網站立場,如需處理請聯(lián)系客服。電話:028-86922220;郵箱:631063699@qq.com。內容未經允許不得轉載,或轉載時需注明來源: 創(chuàng)新互聯(lián)

- 深入分析電子商務網站未來發(fā)展的三大趨勢 2021-04-25

- 電子商務網站建設的特點 2020-07-07

- 重新設計您的移動電子商務網站時不該做什么 2022-10-25

- 電子商務SEO的五個策略 2023-04-01

- 分享電子商務網站產品頁SEO優(yōu)化的六大禁忌 2022-06-04

- 您不應該為電子商務網站使用模板的10個理由 2022-10-26

- 南充電子商務網站應注重品牌建設 2021-01-12

- 如何進行電子商務網頁設計內容解讀 2016-10-02

- 互聯(lián)網電子商務網站運營的一些知識 2015-11-14

- 高端電子商務網站建設的4個注意事項 2022-02-12

- 廣州電子商務網站建設SEO優(yōu)化技巧介紹 2022-05-16

- 農業(yè)電子商務網站建設實現(xiàn)農業(yè)信息的共享流通 2022-02-25