利用hadoop怎么實(shí)現(xiàn)一個(gè)文件上傳功能

本篇文章給大家分享的是有關(guān)利用hadoop怎么實(shí)現(xiàn)一個(gè)文件上傳功能,小編覺得挺實(shí)用的,因此分享給大家學(xué)習(xí),希望大家閱讀完這篇文章后可以有所收獲,話不多說,跟著小編一起來看看吧。

撫順縣網(wǎng)站制作公司哪家好,找成都創(chuàng)新互聯(lián)公司!從網(wǎng)頁(yè)設(shè)計(jì)、網(wǎng)站建設(shè)、微信開發(fā)、APP開發(fā)、成都響應(yīng)式網(wǎng)站建設(shè)等網(wǎng)站項(xiàng)目制作,到程序開發(fā),運(yùn)營(yíng)維護(hù)。成都創(chuàng)新互聯(lián)公司于2013年開始到現(xiàn)在10年的時(shí)間,我們擁有了豐富的建站經(jīng)驗(yàn)和運(yùn)維經(jīng)驗(yàn),來保證我們的工作的順利進(jìn)行。專注于網(wǎng)站建設(shè)就選成都創(chuàng)新互聯(lián)公司。

hdfs上的文件是手動(dòng)執(zhí)行命令從本地linux上傳至hdfs的。在真實(shí)的運(yùn)行環(huán)境中,我們不可能每次手動(dòng)執(zhí)行命令上傳的,這樣太過繁瑣。那么,我們可以使用hdfs提供的Java api實(shí)現(xiàn)文件上傳至hdfs,或者直接從ftp上傳至hdfs。

然而,需要說明一點(diǎn),之前筆者是要運(yùn)行MR,都需要每次手動(dòng)執(zhí)行yarn jar,在實(shí)際的環(huán)境中也不可能每次手動(dòng)執(zhí)行。像我們公司是使用了索答的調(diào)度平臺(tái)/任務(wù)監(jiān)控平臺(tái),可以定時(shí)的以工作流執(zhí)行我們的程序,包括普通java程序和MR。其實(shí),這個(gè)調(diào)度平臺(tái)就是使用了quartz。當(dāng)然,這個(gè)調(diào)度平臺(tái)也提供其它的一些功能,比如web展示、日志查看等,所以也不是免費(fèi)的。

首先,給大家簡(jiǎn)單介紹一下hdfs。hdfs是以流式數(shù)據(jù)訪問模式來存儲(chǔ)超大文件,hdfs的構(gòu)建思路是一次寫入,多次讀取,這樣才是最高效的訪問模式。hdfs是為高數(shù)據(jù)吞吐量應(yīng)用優(yōu)化的,所以會(huì)以提高時(shí)間延遲為代價(jià)。對(duì)于低延時(shí)的訪問需求,我們可以使用hbase。

然后,還要知道hdfs中塊(block)的概念,默認(rèn)為64MB。塊是hdfs的數(shù)據(jù)讀寫的最小單位,通常每個(gè)map任務(wù)一次只處理一個(gè)block,像我們對(duì)集群性能評(píng)估就會(huì)使用到這個(gè)概念,比如目前有多少節(jié)點(diǎn),每個(gè)節(jié)點(diǎn)的磁盤空間、cpu以及所要處理的數(shù)據(jù)量、網(wǎng)絡(luò)帶寬,通過這些信息來進(jìn)行性能評(píng)估。我們可以使用Hadoop fsck / -files -blocks列出文件系統(tǒng)中各個(gè)文件由哪些塊構(gòu)成。

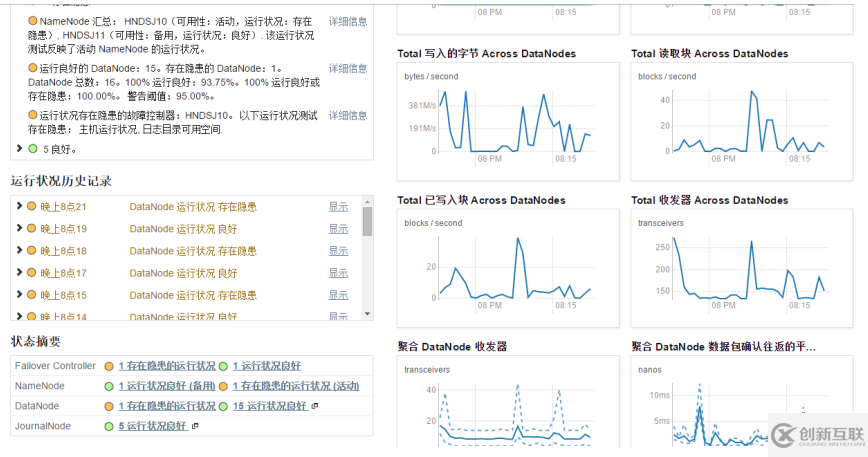

然后,再就是要知道namenode和datanode,這個(gè)在之前的博文已經(jīng)介紹過,下面看看cm環(huán)境中hdfs的管理者(namenode)和工作者(datanode),如下

在yarn環(huán)境中是可以有多個(gè)nameNode的。此環(huán)境中沒有SecondaryNameNode,當(dāng)然也可以有。

好了,關(guān)于hdfs的基本概念就講到這兒了,下面來看看具體的代碼。

一、java實(shí)現(xiàn)上傳本地文件至hdfs

這里,可以直接使用hdfs提供的java api即可實(shí)現(xiàn),代碼如下:

package com.bjpowernode.hdfs.local;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

/**

* ClassName:UploadLocalFileToHdfs <br/>

* Function: 本地文件上傳至hdfs. <br/>

* Date: 2016年3月28日 下午10:06:05 <br/>

* @author qiyongkang

* @version

* @since JDK 1.6

* @see

*/

public class UploadLocalFileToHdfs {

public static void main(String[] args) {

Configuration conf = new Configuration();

String localDir = "/home/qiyongkang";

String hdfsDir = "/qiyongkang";

try{

Path localPath = new Path(localDir);

Path hdfsPath = new Path(hdfsDir);

FileSystem hdfs = FileSystem.get(conf);

hdfs.copyFromLocalFile(localPath, hdfsPath);

}catch(Exception e){

e.printStackTrace();

}

}

}注意,這里hdfs上傳目錄如果不存在的話,hdfs會(huì)自動(dòng)創(chuàng)建,比較智能。

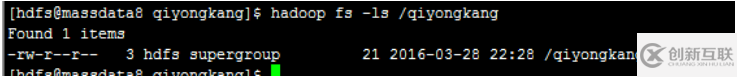

打完包后,上傳至服務(wù)器,執(zhí)行yarn jar mr-demo-0.0.1-SNAPSHOT-jar-with-dependencies.jar,然后執(zhí)行hadoop fs -ls /qiyongkang便可看到:

二、java實(shí)現(xiàn)上傳ftp上的文件至hdfs

首先,我們得準(zhǔn)備一個(gè)ftp服務(wù)器,關(guān)于ftp服務(wù)器的搭建,大家可以查閱資料,筆者就不贅述了。

其實(shí),從ftp上拉取文件上傳到hdfs上,這個(gè)過程大家不要想復(fù)雜了,我們講本地文件上傳到hdfs,其實(shí)就是采用流的方式。因此,我們可以直接讀取ftp上的文件流,然后以流的方式寫入到hdfs。

下面,直接貼出代碼:

package com.bjpowernode.hdfs.ftp;

import java.io.InputStream;

import org.apache.commons.net.ftp.FTP;

import org.apache.commons.net.ftp.FTPClient;

import org.apache.commons.net.ftp.FTPFile;

import org.apache.commons.net.ftp.FTPReply;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FSDataOutputStream;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.IOUtils;

/**

* ClassName:UploadFtpFileToHdfs <br/>

* Function: TODO ADD FUNCTION. <br/>

* Reason: TODO ADD REASON. <br/>

* Date: 2016年3月28日 下午10:50:37 <br/>

*

* @author qiyongkang

* @version

* @since JDK 1.6

* @see

*/

public class UploadFtpFileToHdfs {

public static void main(String[] args) {

Configuration conf = new Configuration();

loadFromFtpToHdfs("172.31.26.200", "qiyongkang", "qyk123456", "/www/input/", "/qiyongkang/", conf);

}

/**

*

* loadFromFtpToHdfs:將數(shù)據(jù)從ftp上傳到hdfs上. <br/>

*

* @author qiyongkang

* @param ip

* @param username

* @param password

* @param filePath

* @param outputPath

* @param conf

* @return

* @since JDK 1.6

*/

private static boolean loadFromFtpToHdfs(String ip, String username, String password, String filePath,

String outputPath, Configuration conf) {

FTPClient ftp = new FTPClient();

InputStream inputStream = null;

FSDataOutputStream outputStream = null;

boolean flag = true;

try {

ftp.connect(ip);

ftp.login(username, password);

ftp.setFileType(FTP.BINARY_FILE_TYPE);

ftp.setControlEncoding("UTF-8");

int reply = ftp.getReplyCode();

if (!FTPReply.isPositiveCompletion(reply)) {

ftp.disconnect();

}

FTPFile[] files = ftp.listFiles(filePath);

FileSystem hdfs = FileSystem.get(conf);

for (FTPFile file : files) {

if (!(file.getName().equals(".") || file.getName().equals(".."))) {

inputStream = ftp.retrieveFileStream(filePath + file.getName());

outputStream = hdfs.create(new Path(outputPath + file.getName()));

IOUtils.copyBytes(inputStream, outputStream, conf, false);

if (inputStream != null) {

inputStream.close();

ftp.completePendingCommand();

}

}

}

ftp.disconnect();

} catch (Exception e) {

flag = false;

e.printStackTrace();

}

return flag;

}

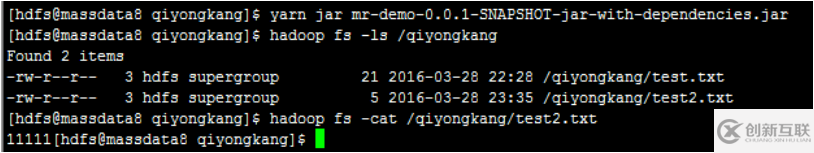

}然后同樣打包上傳后執(zhí)行yarn jar mr-demo-0.0.1-SNAPSHOT-jar-with-dependencies.jar,便可看到:

以上就是利用hadoop怎么實(shí)現(xiàn)一個(gè)文件上傳功能,小編相信有部分知識(shí)點(diǎn)可能是我們?nèi)粘9ぷ鲿?huì)見到或用到的。希望你能通過這篇文章學(xué)到更多知識(shí)。更多詳情敬請(qǐng)關(guān)注創(chuàng)新互聯(lián)行業(yè)資訊頻道。

網(wǎng)頁(yè)標(biāo)題:利用hadoop怎么實(shí)現(xiàn)一個(gè)文件上傳功能

網(wǎng)站路徑:http://vcdvsql.cn/article38/gjeopp.html

成都網(wǎng)站建設(shè)公司_創(chuàng)新互聯(lián),為您提供網(wǎng)站設(shè)計(jì)、品牌網(wǎng)站設(shè)計(jì)、網(wǎng)站營(yíng)銷、網(wǎng)站內(nèi)鏈、網(wǎng)站維護(hù)、微信小程序

聲明:本網(wǎng)站發(fā)布的內(nèi)容(圖片、視頻和文字)以用戶投稿、用戶轉(zhuǎn)載內(nèi)容為主,如果涉及侵權(quán)請(qǐng)盡快告知,我們將會(huì)在第一時(shí)間刪除。文章觀點(diǎn)不代表本網(wǎng)站立場(chǎng),如需處理請(qǐng)聯(lián)系客服。電話:028-86922220;郵箱:631063699@qq.com。內(nèi)容未經(jīng)允許不得轉(zhuǎn)載,或轉(zhuǎn)載時(shí)需注明來源: 創(chuàng)新互聯(lián)

- 響應(yīng)式網(wǎng)站建設(shè)購(gòu)買虛擬主機(jī)要注意哪些細(xì)節(jié) 2020-12-09

- 為什么有些獨(dú)立IP的云主機(jī)會(huì)比共享虛擬主機(jī)的速度慢? 2021-02-14

- 虛擬主機(jī)與虛擬服務(wù)器有何區(qū)別? 2016-11-05

- 企業(yè)為什么要用獨(dú)享ip虛擬主機(jī)? 2021-03-15

- 新手選擇虛擬主機(jī)的五大因素 2022-10-08

- 徐匯做網(wǎng)站告訴你如何判斷虛擬主機(jī)的好壞 2022-09-24

- 全能主機(jī)是什么意思?全能虛擬主機(jī)好用嗎? 2022-10-02

- 什么是網(wǎng)站空間(虛擬主機(jī))? 2020-06-10

- 怎么選擇虛擬主機(jī)服務(wù)商? 2022-07-18

- 網(wǎng)站建設(shè)用云主機(jī)和虛擬主機(jī)的區(qū)別 2015-01-01

- 免備案虛擬主機(jī)適合什么網(wǎng)站使用 2021-02-17

- 網(wǎng)站放選擇什么虛擬主機(jī)更適合做網(wǎng)站優(yōu)化排名 2014-12-14