z-blog網站robots怎么設置

創(chuàng)新互聯建站導讀:zblog的系統文件不需要被抓取,但正常情況下搜索引擎也不會去抓取,所以設置與否其實沒有很大影響。不想麻煩的話,直接全部開放抓取即可;實在不放心的,也可以去做下限制。

成都創(chuàng)新互聯專注于紅山企業(yè)網站建設,成都響應式網站建設,成都做商城網站。紅山網站建設公司,為紅山等地區(qū)提供建站服務。全流程按需設計,專業(yè)設計,全程項目跟蹤,成都創(chuàng)新互聯專業(yè)和態(tài)度為您提供的服務

問題:z-blog網站robots怎么設置?

回答:這個是問題是筆者看到有朋友在搜外上提問,穩(wěn)到zblog網站robots文件設置的問題。具體內容如下:

為什么z-blog很多模板商、或者SEO插件商都推薦下面這種robots寫法?? 除了安裝文件就這兩個文件為什么要全禁止了?

怪的是全部禁止后通過站長工具檢測居然是正常的,原理是什么回事,百度蜘蛛也都能正常抓取嗎?

User-agent: *

Disallow: /zb_users/

Disallow: /zb_system/

Sitemap:

首先解釋下,前面robots代碼里寫到的,是禁止zb_users和zb_system文件目錄下文件被搜索引擎抓取,這樣寫是沒有錯的。因為這兩個目錄下的文件沒有被抓取的必要。

那么為什么禁止蜘蛛抓取了,站長工具測試還是正常能抓取呢?原因可能有三個:

1、robots文件沒有上傳成功;

2、robots文件在搜索引擎那里沒有更新;

3、站長工具檢測不準。

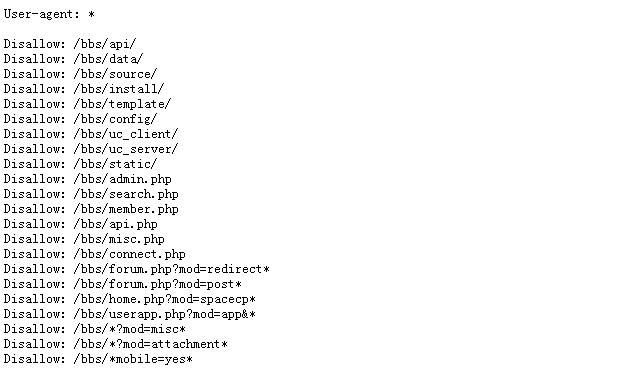

解釋了問題出現的原因,我們再來看看z-blog網站robots怎么設置。本站的主程序就是zblog的,來看看本站的robots文件,如下圖:

可以看到對于主站的zblog程序,筆者并沒有設置任何的限制抓取,只是對于目錄下的bbs論壇做了限制。事實上這沒有任何的問題,也就是說對于zblog我們無需糾結哪些目錄文件需要禁止抓取,直接開放全部抓取也不會出現影響。

robots文件的作用的確是存在的,對于內容比較多的大站來說,通過robots的設置,可以有效的調節(jié)蜘蛛抓取的資源。比如說商城網站會出現很多的幫助文檔,這些幫助文檔就可以通過robots的設置來限制抓取,從而節(jié)省了蜘蛛抓取頻次。但是大家要注意一個問題,那就是對于那些正常不需要被抓取的頁面,設置robots還是有必要的,但是對于zblog這種系統文件,設置與否其實無關緊要。如果硬是要去設置的話,按照前面代碼那樣做,是可以的。

關于z-blog網站robots怎么設置的問題,筆者就簡要的說這么多。總之來說就是,zblog的系統文件不需要被抓取,但正常情況下搜索引擎也不會去抓取,所以設置與否其實沒有很大影響。不想麻煩的話,直接全部開放抓取即可;實在不放心的,也可以去做下限制。

當前標題:z-blog網站robots怎么設置

路徑分享:http://vcdvsql.cn/article6/ddpeig.html

成都網站建設公司_創(chuàng)新互聯,為您提供品牌網站建設、營銷型網站建設、云服務器、網站內鏈、建站公司、網站導航

聲明:本網站發(fā)布的內容(圖片、視頻和文字)以用戶投稿、用戶轉載內容為主,如果涉及侵權請盡快告知,我們將會在第一時間刪除。文章觀點不代表本網站立場,如需處理請聯系客服。電話:028-86922220;郵箱:631063699@qq.com。內容未經允許不得轉載,或轉載時需注明來源: 創(chuàng)新互聯

- 影響網站排名的因素網站參與率 2015-01-03

- 移動網站建設Web的局限性與用戶期望 2013-11-20

- 網站策劃推廣改版方案 2014-01-05

- 長尾關鍵詞優(yōu)化該如何去做 2016-10-30

- 企業(yè)網站如何提升網站排名 2016-08-10

- 針對某一個關鍵詞優(yōu)化的技巧和心得 2016-10-04

- 網站seo優(yōu)化中做好用戶體驗都包括哪些方面 2016-04-05

- 如何擺脫APP開發(fā)推廣的困局 2016-11-22

- 怎么選擇適合seo網站排名的好域名? 2013-10-13

- 百度關鍵詞優(yōu)化前須知的必備手冊是什么? 2015-11-11

- 新營銷型企業(yè)網站排名不穩(wěn)定的原因是什么? 2015-10-17

- SEO優(yōu)化-偽靜態(tài)頁面制作技巧與優(yōu)點解析 2016-09-23